了解ChatGPT背后的技术原理

聊聊ChatGPT,大家肯定知道它是个超级智能的聊天机器人,但它到底是怎么“聪明”起来的?今天咱们就用最简单的话,帮你了解ChatGPT背后的技术秘密。

什么是ChatGPT?

先说基础,ChatGPT其实是基于“GPT”(Generative Pre-trained Transformer)技术的AI语言模型。它能理解你输入的文字,并且生成符合语境、连贯自然的回复。GPT是由OpenAI开发的,目前最新版本(比如GPT-4)更加强大,能写文章、编代码,甚至能画画(结合多模态技术)。

核心技术:Transformer架构

ChatGPT的大脑叫“Transformer”,这是2017年被提出的一种神经网络架构。它的厉害之处在于:

-

注意力机制(Attention):能重点关注句子中的关键信息,理解上下文。

-

并行计算:让训练速度快很多。

这两点让ChatGPT能在庞大数据里学习语言规律,生成更自然的回答。

预训练+微调

ChatGPT的训练过程分两步:

-

预训练:模型在海量文本数据上学习语言结构、词汇用法,像是在读成千上万本书。

-

微调:用更具体的对话数据训练,让它更懂得如何跟人“聊天”,表现得更贴心、更有逻辑。

这个流程保证ChatGPT既懂语言,又适合实际应用。

大规模数据和计算力支持

你能看到的流畅回答,背后是大量数据和超强算力支撑。训练ChatGPT需要数以百亿计的参数,这意味着它能捕捉语言中非常细微的语义和关系。

此外,OpenAI用超级计算机来训练它,耗费大量时间和资源。正是这些,成就了ChatGPT的强大。

自然语言处理(NLP)技术

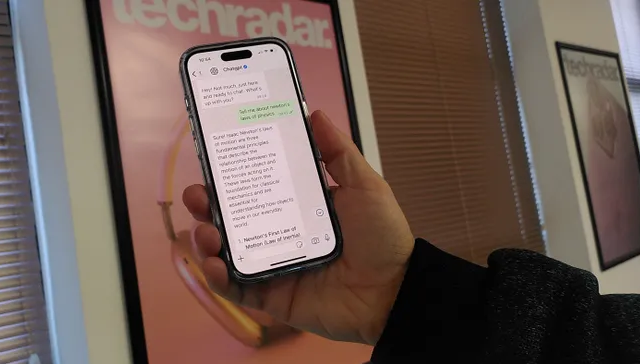

ChatGPT是NLP技术的产物,主要任务是“理解”和“生成”人类语言。它可以:

-

理解上下文,准确把握问题的含义。

-

生成连贯回答,让对话自然流畅。

-

处理多种语言,支持跨语言交流。

这些能力让它能胜任写作助手、客服机器人、学习辅导等多种应用。

持续改进与反馈学习

ChatGPT并不是“做完就完事”的产品,它还在不断进步。OpenAI会根据用户反馈和使用数据,持续优化模型表现。通过“强化学习”,ChatGPT学会更好地理解人类意图,避免错误和偏差。

总结

简单来说,ChatGPT是靠Transformer架构、海量数据和强大算力训练出来的语言模型。它能理解你的提问,并生成自然、贴切的回答,背后是预训练、微调和持续优化的技术支撑。